Qu’est-ce que le «Data Sampling» ou échantillonnage de données en analytics ?

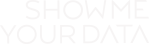

Pour traiter un volume important de données et assurer un traitement rapide de cette masse de données, la technique du data sampling est encore très largement utilisée au moment même où l’on ne parle que de « Big Data ».Concrètement plutôt que de prendre l’intégralité des données pour présenter les métriques dans un rapport, il s’agit ici de prendre un échantillon suffisamment représentatif d’une population pour extrapoler le résultat et le transposer sur la population réelle (c’est le cas pour tous les sondages et études issues de panels). En analytics, cette technique présente l’avantage de pouvoir restituer de manière instantanée les données (sans consommer trop de ressources de traitement du côté de l’éditeur, donc minimiser le cout de traitement, et oui le big data gratuit cela n’existe pas encore!). En revanche, la fiabilité et l’intégrité des données peuvent être remise en question. Pour illustrer cette technique, prenons l’exemple de 100 visites générant 10 transactions réalisées sur 10 jours, 3 tailles d’échantillons 10, 20 et 30% donnent des résultats différents:

Au final, on constate rapidement que des intervalles de données hétérogènes peuvent donner des résultats assez éloignés de la réalité, conclusions :

- Plus la taille de l’échantillon est grande, plus le résultat sera proche de la réalité.

- Les échantillons doivent être statistiquement représentatifs.

- La répartition des données a un impact important sur le résultat quand les sets de données ne sont pas distribués de manière homogène.

Pour un site eCommerce avec plusieurs millions de visites par mois les résultats seront assez fortement impactés sur certains types de rapports d’autant plus que les campagnes marketing sont lancées de manière non linéaire .

Le Data sampling dans les rapports Google Analytics

Coté Google Analytics, l’échantillonnage de données est systématique dans plusieurs cas, mais un autre problème est soulevé, c’est l’homogénéité des échantillons qui n’est pas contrôlée, autrement dit la cohérence des sets de données analysées. Quelques exemples de limitations :

- Les rapports basés sur plus de 250 000 visites.

- Les rapports non natifs de plus de 500 000 visites ( c.-à-d. quand on ajoute une dimension)

- Les rapport de Visualisation de Navigation dès 100 000 visites

- Les rapports qui exploitent plus de 1 000 000 de lignes pour une dimension unique

- Les rapports utilisant la segmentation dès 200 000 visites.

- Les rapports Multi channel dès qu’il y a 1 000 000 de chemins différents

Au final, les rapports critiques qui sont concernés sont ceux relatifs à la conversion et les rapports segmentés, les données remontées peuvent souvent sembler incohérentes, même en ajustant l’échantillonnage via l’interface.

Les solutions de contournement au data sampling :

Pour pallier à cette limite bloquante pour l’analyse fine de données, plusieurs solutions existent :

1. Fractionner les requêtes :

Dans certains cas, il est possible de fractionner les requêtes en plusieurs séquences afin de n’obtenir que des résultats non échantillonnés. Pour ce, il faudra impérativement passer par l’API Google Analytics.

2. Ajuster la taille de l’échantillon au niveau de la collecte.

Cette technique consiste à définir le seuil d’échantillonnage au niveau du code analytics. On réduit le nombre de mesures collectées donc les données collectées sont minimisées. Cette technique n’apporte pas de solution en soit car elle revient à déplacer le problème !

3. Travailler sur des échantillons plus petits

En réduisant la période d’analyse ou supprimant des dimensions additionnelles. Cette solution n’étant pas totalement satisfaisante car cela revient à réduire la taille de la population analysée ou limiter son analyse en terme de granularité.

4. Souscrire à Google Analytics Premium

Le traitement de données ayant un coût, il est normal que cette fois Google vous fasse payer l’addition, non !

5. Choisir une autre solution analytique payante

Tous les éditeurs analytiques échantillonnent plus ou moins les données pour les très fortes volumétries mais il est possible d’obtenir des données non agrégées dans certains cas, c’est là l’un des intérêts d’une solution payante. Cela est d’autant plus justifié que les méthodes d’échantillonnage sont connues, ajustables et maitrisées par les éditeurs de solutions analytiques.

Il existe également d’autres limites au niveau de la collecte de données mais ce n’est pas l’objet de cet article. Si vous souhaitez en savoir plus, n’hésitez pas à nous contacter pour une consultation.

1 Avis

Merci pour cet article qui est encore trop (malehureusement) rare !

Complétement d’accord avec vous ! On arrive à faire passer un aveu de faiblesse pour une force…

Vous trouverez un article, en 2 parties, écrit par Jean Marie Camaiade sur le mythe du Sampling vertueux : http://blog.atinternet.com/fr/index.php/2012/11/06/tendances/le-mythe-du-sampling-1/2413

Merci pour cet article.